原创文章,转载、引用请注明出处!

Image Super-Resolution with Cross-Scale Non-Local Attention and Exhaustive Self-Exemplars Mining

CVPR 2020

立意

文章指出,传统SISR方法着眼于LR图像,主要集中在局部先验和非局部先验的匹配和重建上。特别是基于局部先验(双线性、双三次插值)的方法,仅仅通过相邻像素的加权和来重建像素。

自然图像中广泛存在跨尺度的块相似性。

基于上述两点,为了突破局部限制,考虑基于非局部均值滤波的方法:即整个LR图像上全局搜索相似的块。也就是说,除了非局部像素对像素的匹配外,像素还可以与较大的图像块进行匹配。

对于SISR任务来说,由于自然的跨尺度特征对应关系,可以直接从LR图像中搜索高频细节。

论文主要有以下三点贡献:

提出了用于SISR任务的第一个跨尺度非局部(CS-NL)注意力模块,计算图像内部的像素到块以及块到块的相似性。

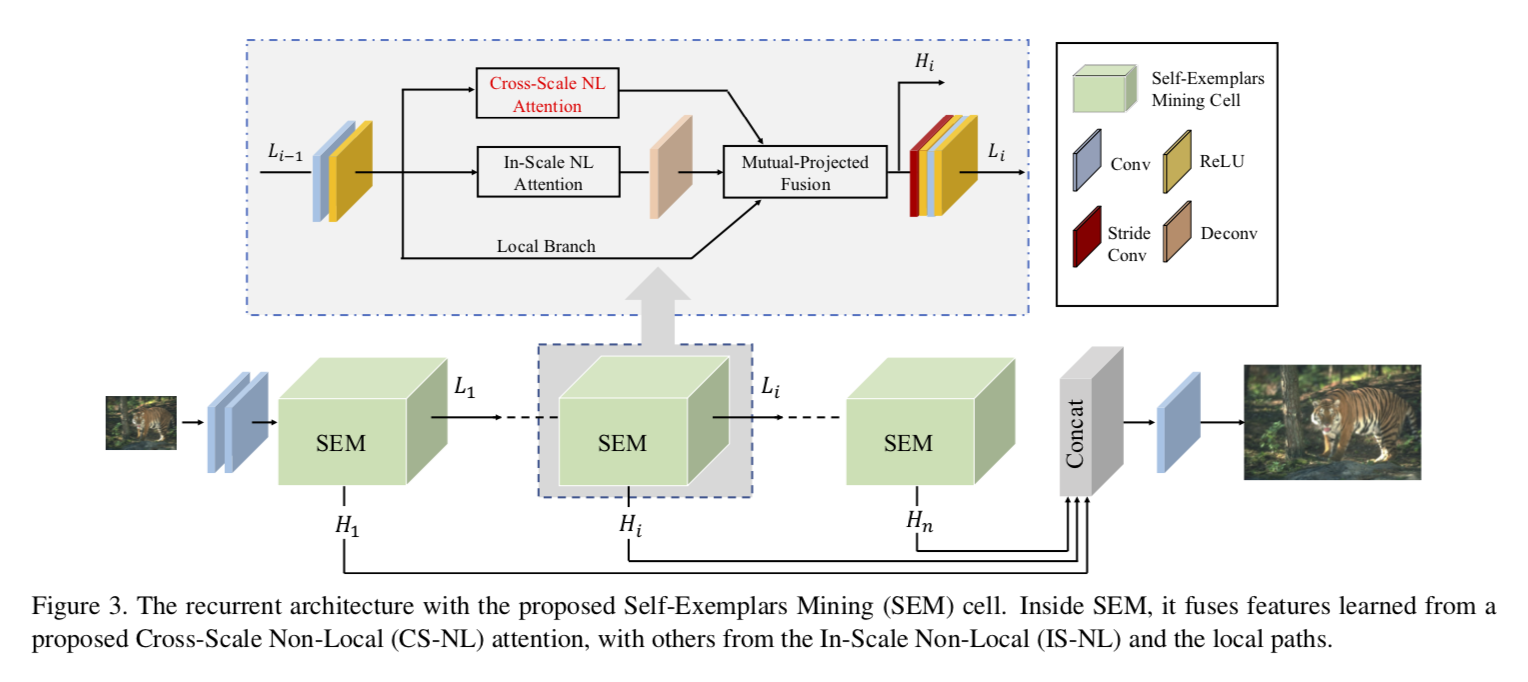

提出了一个强大的SEM单元,在单元内部,通过结合

局部、尺度内非局部和跨尺度非局部特征相关性,尽可能挖掘更多的的先验信息。该网络在多个图像基准数据集上达到了最佳性能。

模型

In-Scale Non-Local (IS-NL) Attention

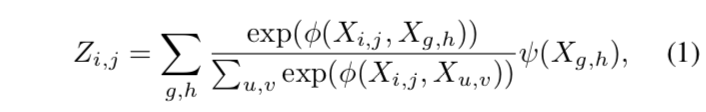

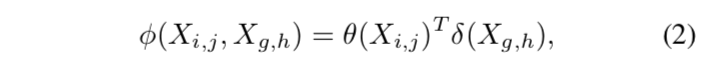

非局部注意可以通过从整体图像中总结相关特征来探索自我样本。形式上,给定图像特征映射X,非局部注意定义为

其中,(i,j)、(g,h)和(u,v)是X的坐标对,ψ(·)是特征变换函数,φ(·,·) 是用来衡量相似性的相关函数,定义为

其中,θ(·)、δ(·)是特征变换。

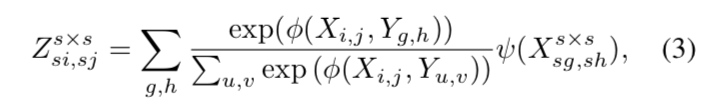

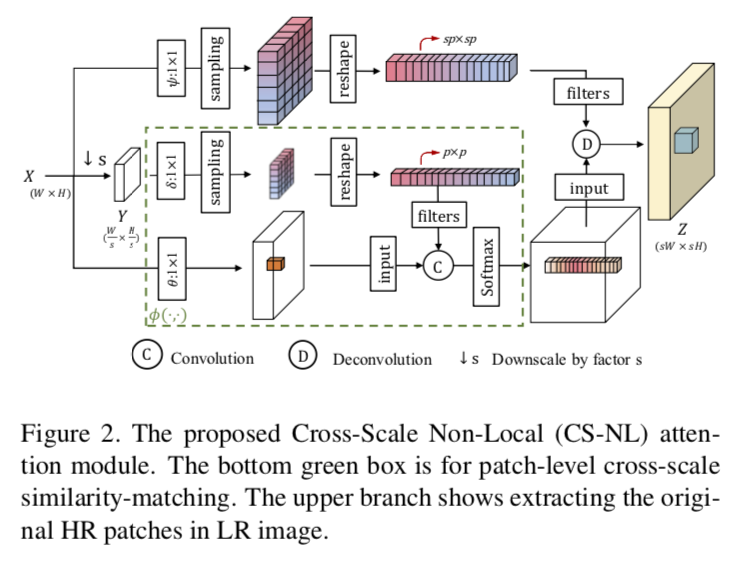

Cross-Scale Non-Local (CS-NL) Attention

CS-NL注意是建立在IS-NL注意的基础上的,主要做法是:在根据比例s下采样过的图像中寻找特征Y=X中的候选特征。下采样操作是双线性插值。

这样做的原因是,由于空间维度的差异,使用公共相似性度量直接将像素与patch匹配是不可行的。因此,只需对特征进行降采样,将patch表示为像素,并测量其距离(affinity)。

The reason to do so is because directly matching pixels with patches using common similarity measurement is infeasible due to spatial dimension difference. So we simply downsample the features to represent the patch as pixel and measure the affinity.

IS-NL公式扩展到CS-NL版本:设缩放比例为s为了计算像素和patch的相似性,首先需要从X(w×h)到Y(w/s×h/s)进行下采样,找到X和Y的pixel-wise相似性,最后使用相应的s×s patch重建X,输出是Z(sh×sh)。

CS-NL attention module的流程:

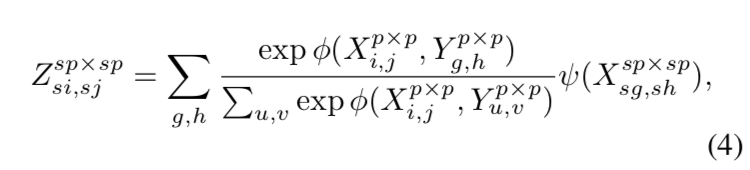

Patch-Based Cross-Scale Non-Local Attention

CS-NL attention 的距离(affinity)度量可能存在问题。

First, high-level features are robust to transformations and distortions, that is rotated/distorted low-level patches may yield same high-level features.

Besides, adjacent target regions are generated in a non-overlapping fashion, possibly creating discontinuous region boundaries artifacts.

给出新的公式:

p×p给出了非1的patch大小,当p=1的时候就回归了CS-NL。

解释原理是上一个公式,代码里用的是这一个公式。

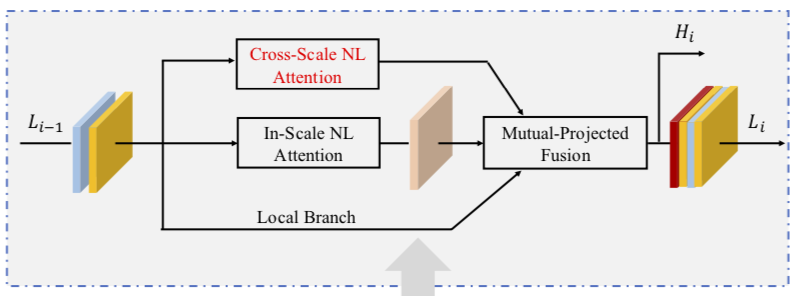

Self-Exemplars Mining (SEM) Cell

Multi-Branch Exemplars

Local Branch不对Li-1做任何操作,直接搬过来;Cross-Scale NL Attention前面提过;In-Scale NL Attention计算的是特征图内像素间的非局部相似性。

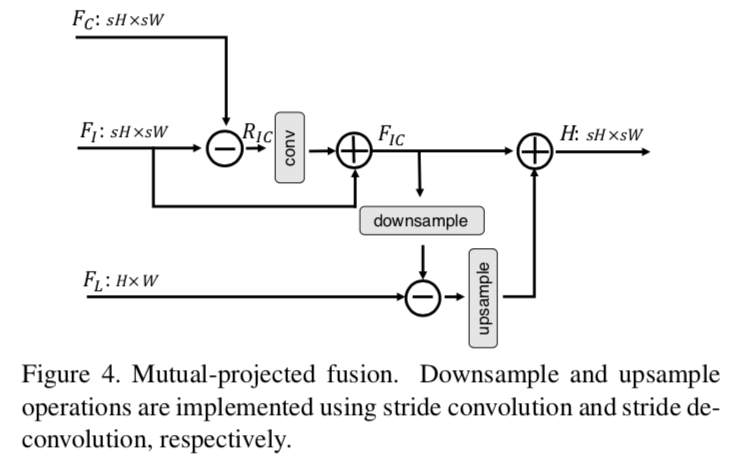

Mutual-Projected Fusion

将三部分的特征进行融合:

式(5)-(8)

实验

实验设置

训练集:DIV2K(800 images)

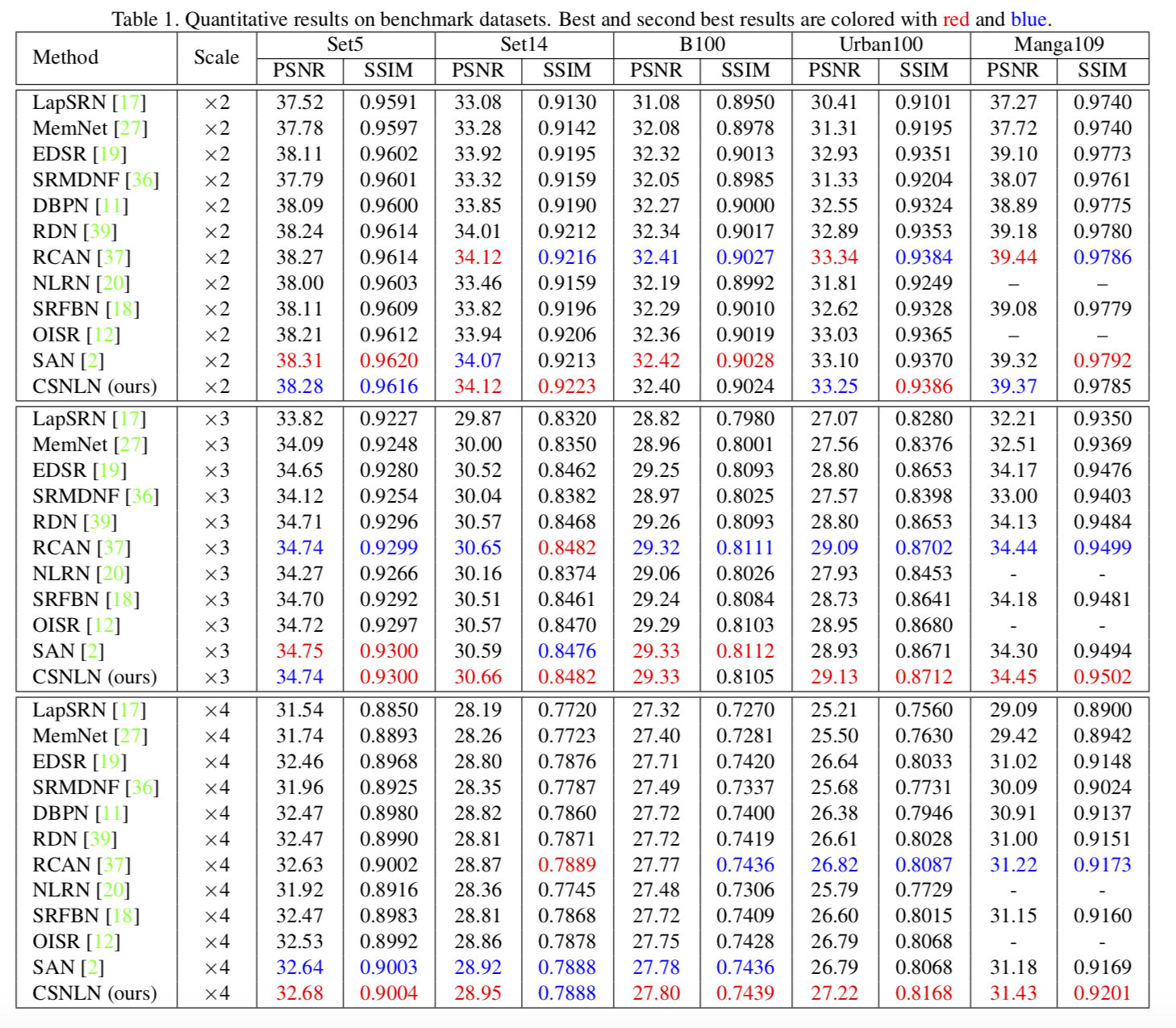

测试集:Set5, Set14, B100, Urban100, and Manga109

SEM:12

p = 3

定量试验

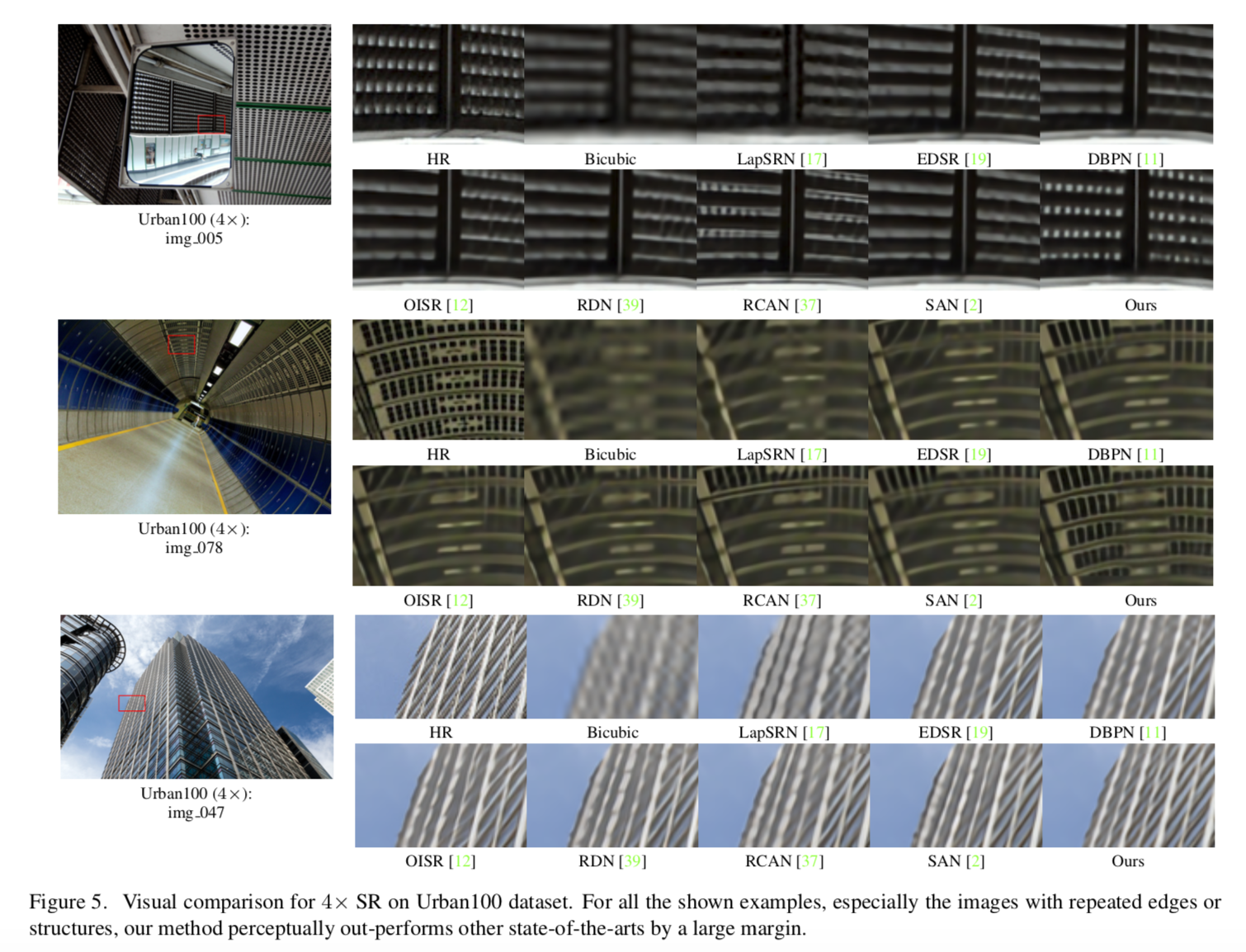

定性试验

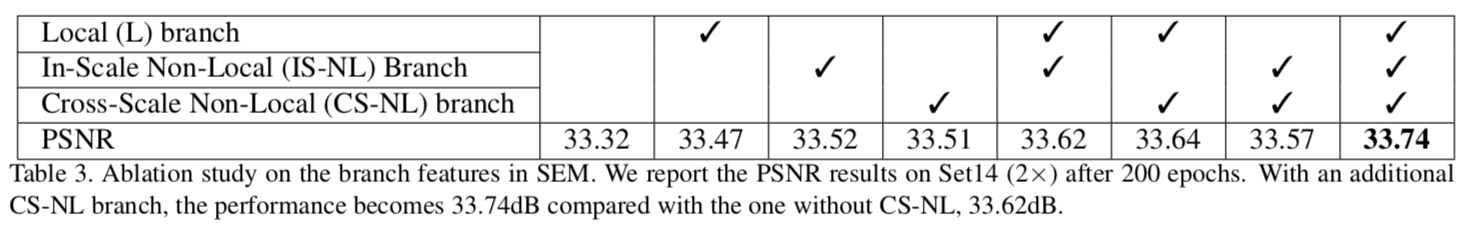

branch效果对比

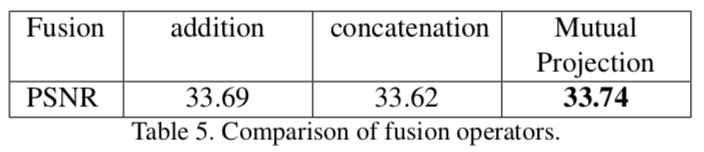

branch融合方式对比

其他

感想

从文章的结果来看,用相似块来做SR的这个思路是非常成功的,也符合自然的想法,合理是非常合理的总之。

实验做的很细,但感觉少了一个非常重要的内容,就是SEM的数量问题。p的大小是做了实验的,上面没放。

最终的对比结果里,用了注意力机制的都是效果不错的,还是要多关注Attention。