原创文章,转载、引用请注明出处!

Learning Texture Transformer Network for Image Super-Resolution

CVPR 2020

立意

文章指出,现有的超分辨率方法忽略了使用注意力机制从Ref图像传输高分辨率的纹理。

使用高分辨率图像作为参考,把这个称为Ref,同SISR是两种不同的范式,abstract和introduction里提到。

We study on image super-resolution (SR), which aims to recover realistic textures from a low-resolution (LR) image. Recent progress has been made by taking high-resolution images as references (Ref), so that relevant textures can be transferred to LR images.

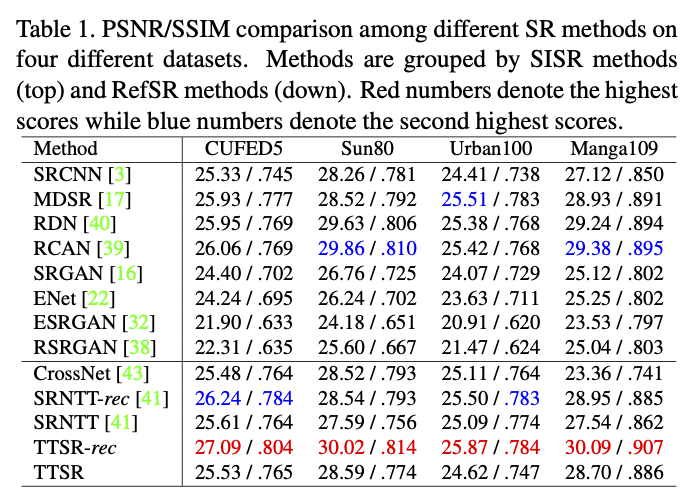

The research on image SR is usually conducted on two paradigms, including single image super-resolution (SISR), and reference-based image super-resolution (RefSR).

However, existing SR approaches neglect to use attention mechanisms to transfer high-resolution (HR) textures from Ref images, which limits these approaches in challenging cases.

解决思路:TTSR,其中有4个模块。最大的贡献:最早将transformer体系结构引入图像生成任务。

方法

Texture Transformer

用于纹理变换的transformer,也是本文的核心。

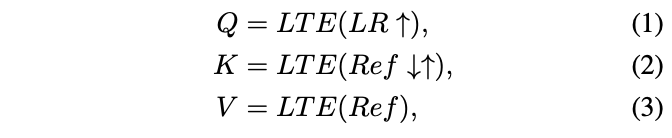

Learnable Texture Extractor (LTE)

过去通常使用预训练好的VGG网络提取特征,LTE是被设计用来进行特征提取的提取器,这里可以自设训练,在超分过程中训练从而更好地提取跨LR和Ref的联合特征。

其中LR↑是对原始LR图像经过bicubic上采样得到的,Ref↓↑是通过同样的核先下采样再上采样得到,使和LR↑是domain-consistent。

Relevance Embedding (RE)

RE的目的是通过估计Q和K之间的相似度来估计LR和REF图像之间的相关性。

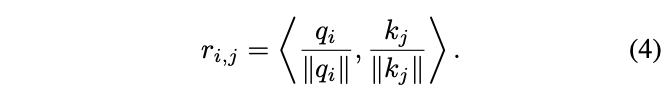

LTE提取的Q和K被分成多个patch,其中每个patch可以分别表示为:

计算q和k的归一化内积,作为相似度:

R是没有出现在图上的,R是RE的结果,H和S是通过它得到的。

Hard-Attention (HA)

传统的注意力机制会直接计算qi与V的加权和,作者认为这样会造成模糊。具体原因是由于Ref图像和LR图像之间的domain gap比较大导致直接这样模型会缺乏传递HR纹理特征的能力。HA则用来传递Ref图像中纹理特征以解决这个问题。

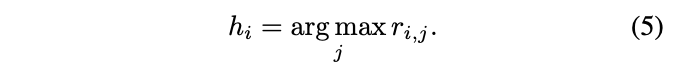

计算HA map:

hi是一个索引值,表示Ref图像中和LR图像中第i个patch最相关的patch的索引。根据这个值去V中索引得到最相关的纹理特征T。

Soft-Attention (SA)

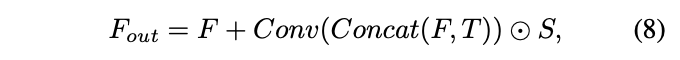

HA是负责找出Ref特征中和LR图像特征相关较强的部分从而建立对应关系,SA是负责将两个特征通过加权的方式更好地融合。

跳过的公式7就是从HA map中找到最大的(Max)那个。

Cross-Scale Feature Integration (CSFI)

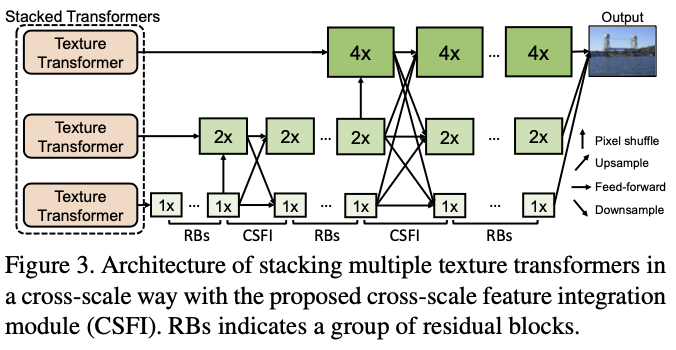

通过堆叠Texture Transformer可以实现不同倍数的放大,作者提出了一个跨尺度特征集成模块(CSFI)在不同尺度的特征之间交换信息。

Loss Function

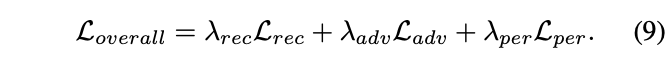

线性组合Loss,三部分组成:

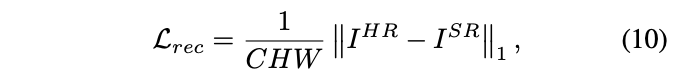

Reconstruction loss:就是L1。大家都认为这个比L2强。

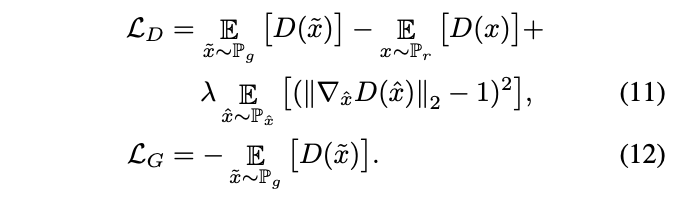

Adversarial loss:参照WGAN-GP。提出用梯度范数的惩罚来代替权重裁剪加粗样式,使得训练更加稳定,性能更好。

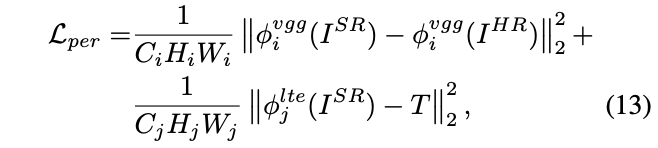

Perceptual loss:SRGAN里已经详细提到过了。感知损失的关键思想是增强预测图像与目标图像在特征空间上的相似性,这里包含两部分,第一部分是传统的基于VGG19的特征。第二部分是转移感知损失(transferal perceptual loss),对应LTE提取的特征,这种传递感知损失限制了预测的SR图像与传递的纹理特征T具有相似的纹理特征,这使得作者的方法更有效地传递Ref纹理。

实验

实验设置

可学习纹理提取器包含5个卷积层和2个池层,它们以三种不同的尺度输出纹理特征。为了减少时间和GPU内存的消耗,相关性嵌入只应用于最小尺度,并进一步传播到其他尺度;

鉴别器G:我们采用了SRNTT中使用的相同网络,并删除了所有BN层;

数据增广:随机水平和垂直翻转,然后随机旋转90,180和270;每个minibatch包含9块大小为40×40的LR patch,以及9块大小为160×160的HR和Ref patch;

组合Loss的权重:Lrec、Ladv和Lper的权重系数分别为1、1e-3和1e-2;

优化器:使用β1=0.9、β2=0.999和ǫ=1e-8的Adam opti-mizer;

学习率:1e-4;

训练策略:前2个epoch只用Lrec,之后将所有的Loss都用上后训练50个epoch;

这部分写在原文的method的最后,也就是3.4,没放在4.1去写。

数据集:CUFED5【41】,训练集包含11871对,每对由输入图像和Ref图像组成;测试集共有126幅测试图像,每幅图像由4幅相似程度不同的Ref图像组成;

额外数据集1:Sun80【26】包含80幅自然图像,每幅图像都有多幅Ref图像;

额外数据集2:Urban100【11】,该数据集没有Ref图像,将其LR图像视为Ref图像。由于Urban100都是具有强自相似性的建筑图像,因此这种设计可以实现显式的自相似搜索和传输过程;

额外数据集3:Manga109【20】,同样缺少Ref图像,随机抽取该数据集中的HR图像作为Ref图像;

评价指标:在YCbCr空间的Y通道上,对SR结果进行了PSNR和SSIM评估。

定量实验

定性实验

可视化:

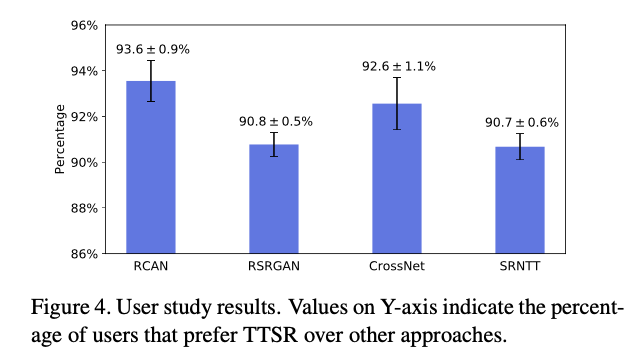

用户调研:对RCAN【39】、RSR-GAN【38】、CrossNet【43】和SRNTT【41】,10名受试者,在CUFED5测试集上收集了2520张选票。对于每个比较过程,我们为用户提供两个图像,其中包括一个TTSR图像。要求用户选择视觉质量更高的。其中Y轴上的值表示倾向于TTSR而非其他方法的用户的年龄百分比。超过90%的用户投票支持的TTSR。

用户调研这里很像LPIPS中的用户调研,都是同时给你两张图让你选更清楚的。

消融实验

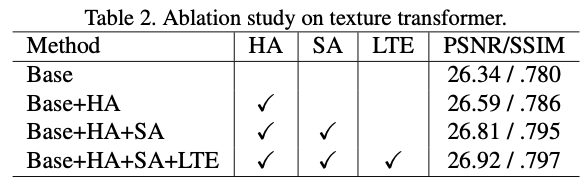

Texture Transformer中模块的影响

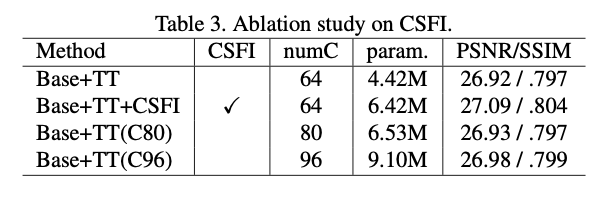

CSFI的影响

第一行显示了仅使用TT时我们模型的性能,而第二行证明了CSFI的有效性,它使PSNR指标增加了0.17。

为了验证性能的改善不是由参数大小的增加带来的,将“Base+TT”模型的信道数增加到80和96。“Base+TT(C80)”几乎没有增长,其参数数几乎与“Base+TT+CSFI”相同。“Base+TT(C96)”将参数数量增加到9.10M也没有增长。CSFI可以以相对较小的参数大小有效地利用参考纹理信息。

Adv loss和Transferal per loss的影响

两幅图,不重要。

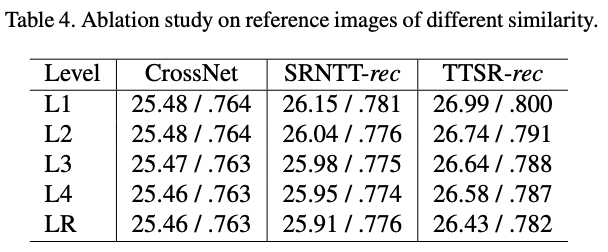

不同的Ref图像相关性的影响

为了研究LR和Ref图像之间的相关性如何影响TTSR的结果,在CUFED5测试集上进行了实验。其中,“L1”至“L4”表示CUFED5测试集提供的参考图像,其中L1是最相关的级别,而L4是最不相关的级别。“LR”是指使用输入图像本身作为参考图像。使用L1作为参考图像的TTSR实现了最佳性能。当使用LR作为参考图像时,TTSR的性能仍然优于以前最先进的RefSR方法。

一张图像的LR难道不应该是最相关的?还是说这个数据集的组成并不是依靠两个客观指标的计算来定义参考图像是否相关???

其他

感想

Transformer能够用来做很多事情,在看这篇文章之前,以为是一transformer的领域迁移为核心的创新是最大亮点,确实是,但占比重没有绝对的高,文章还设计了自己的方法流程用来解决超分辨率问题,就是CSFI。

对比实验做的非常的细,该论证到的内容都论证到了。没有提供太高倍数的模型估计是因为计算量的问题,毕竟CSFI是级联的结构,想一想就知道高倍数需要的参数量估计很大。

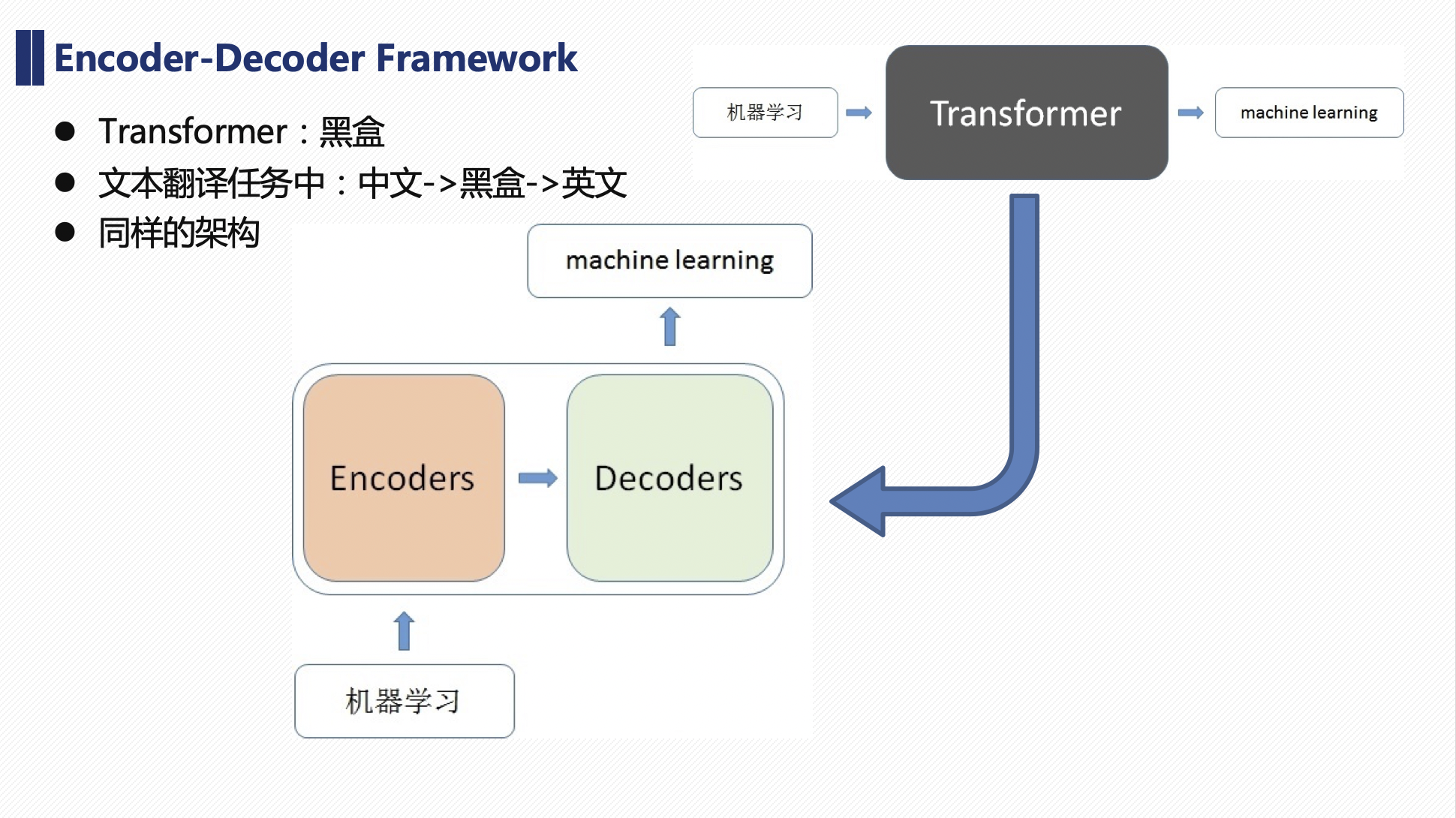

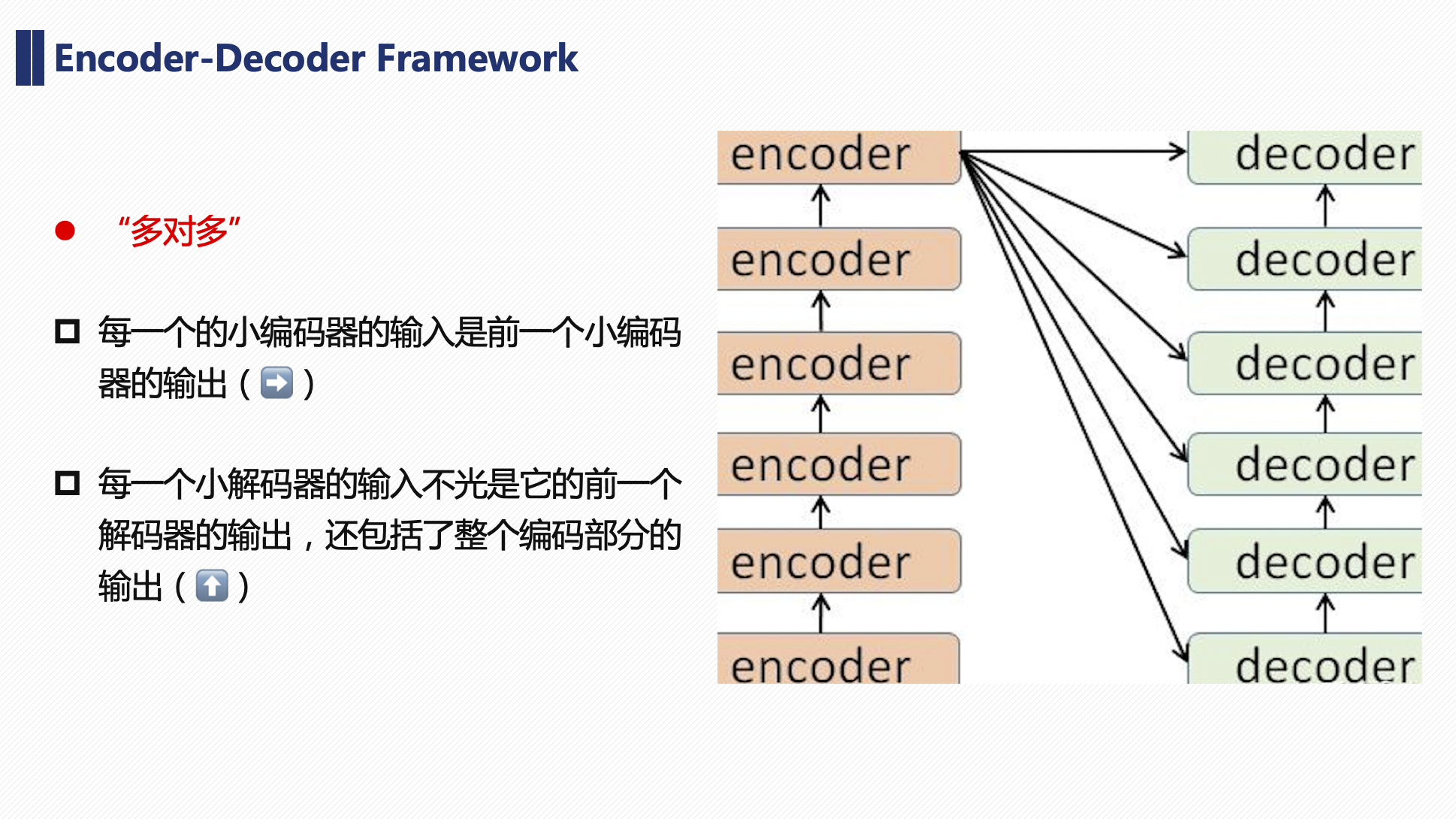

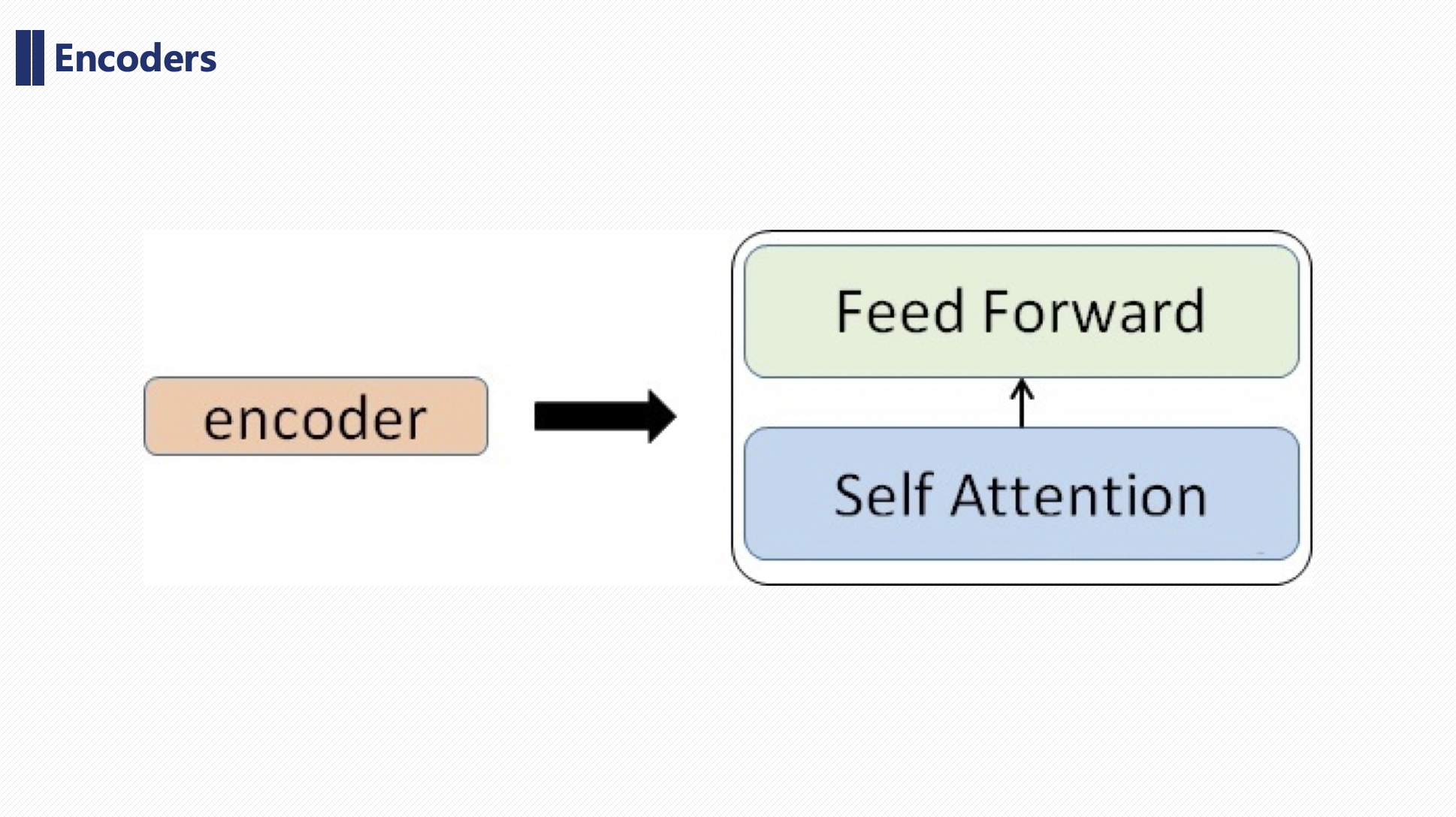

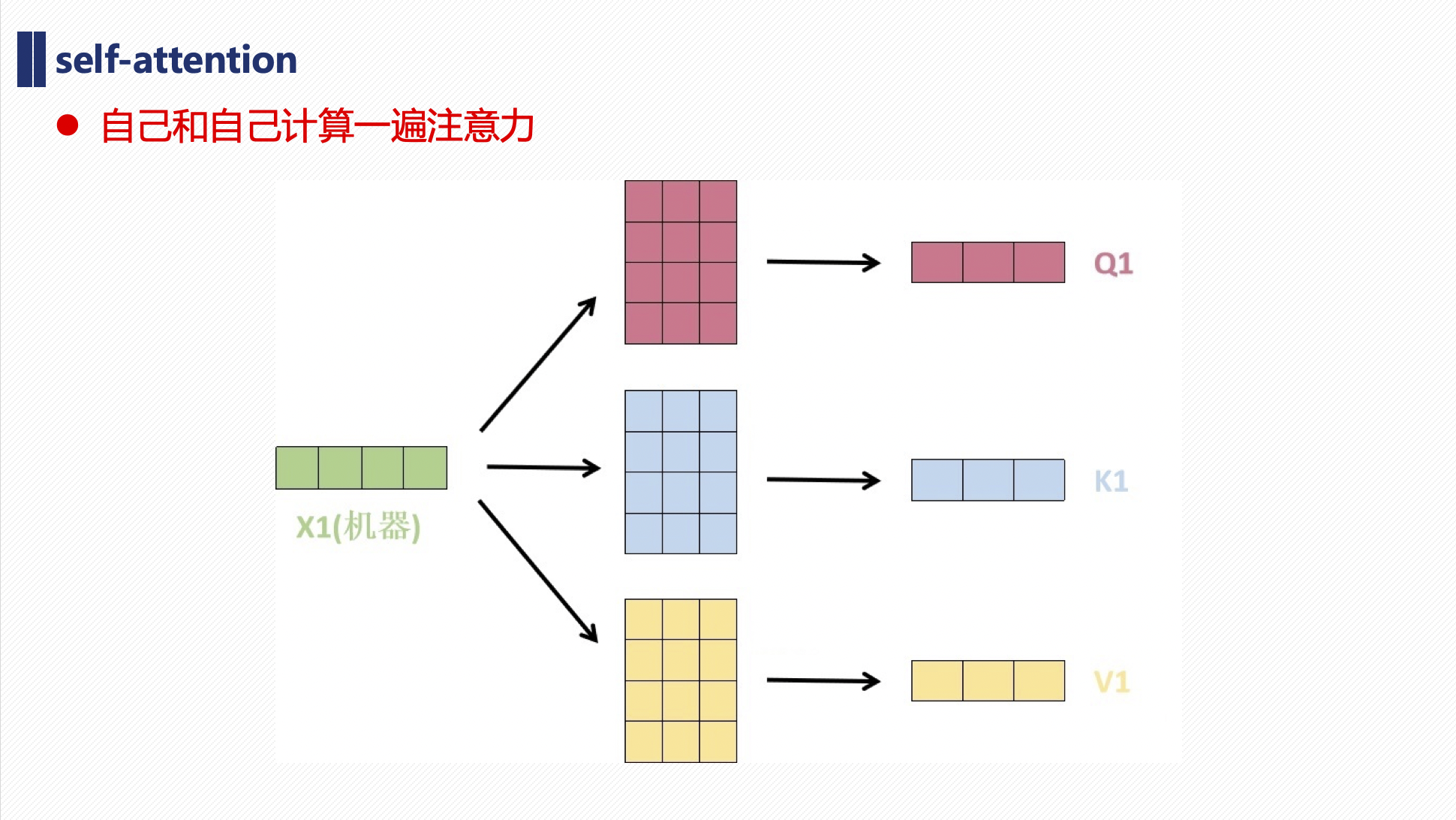

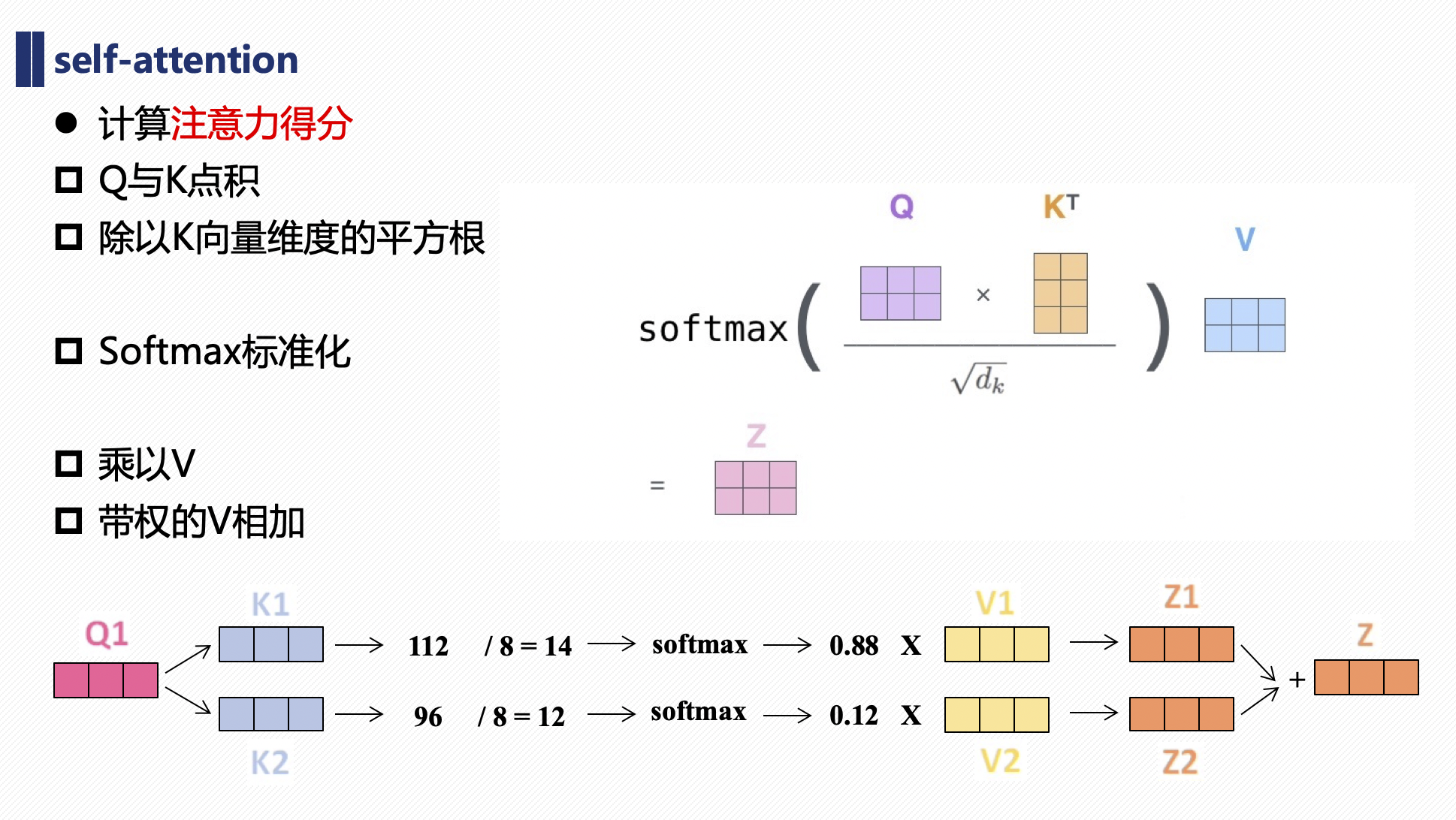

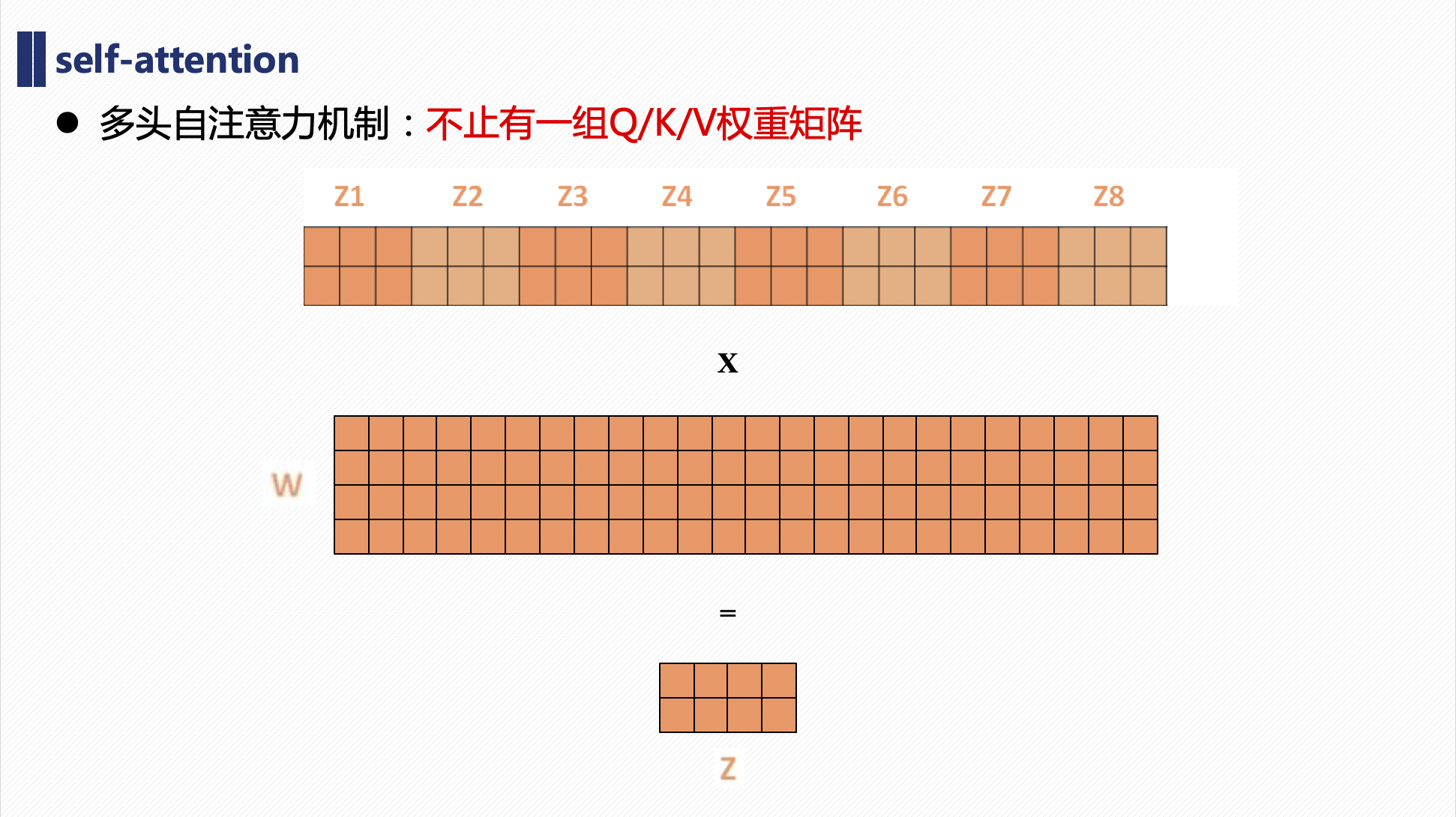

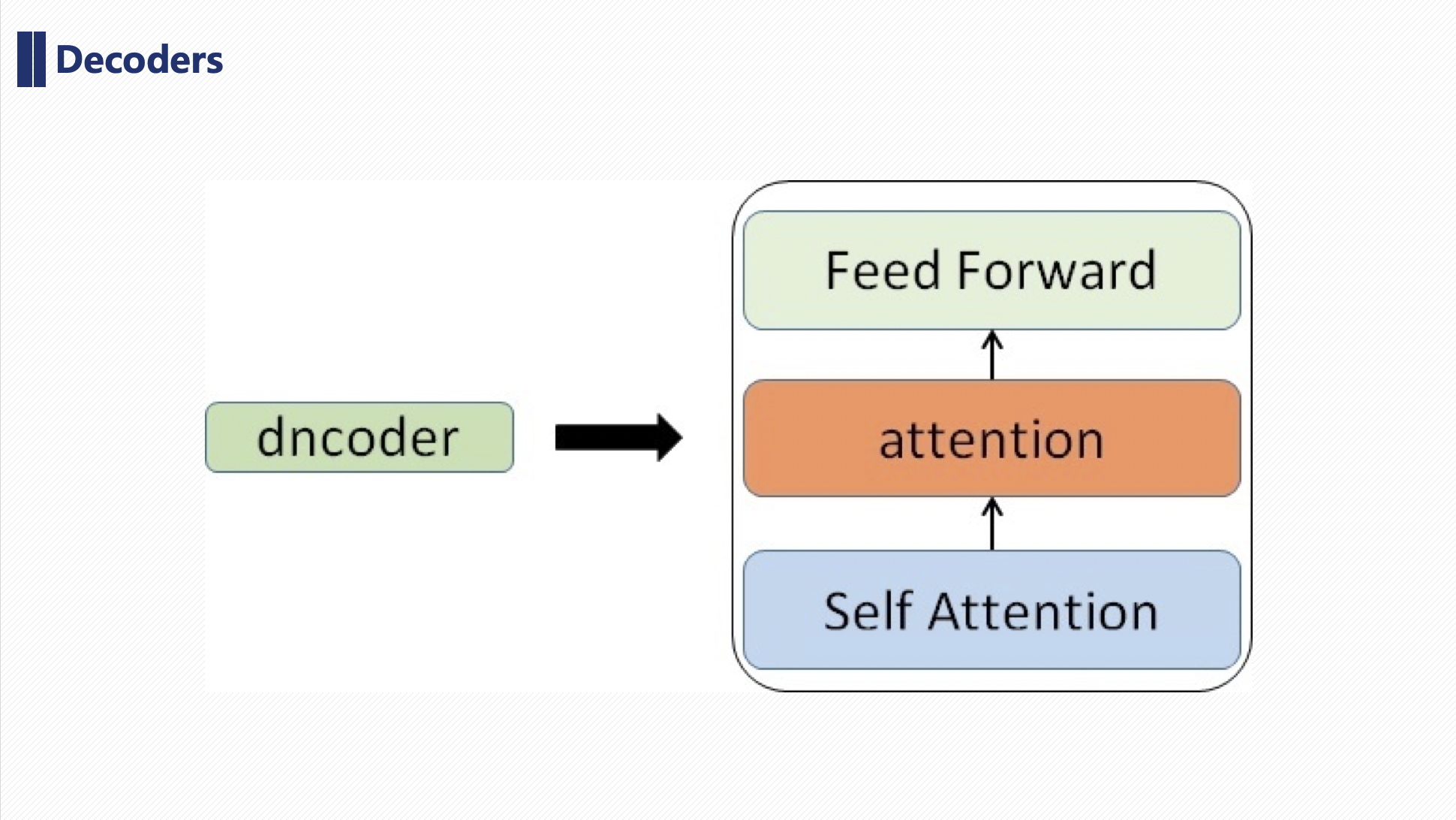

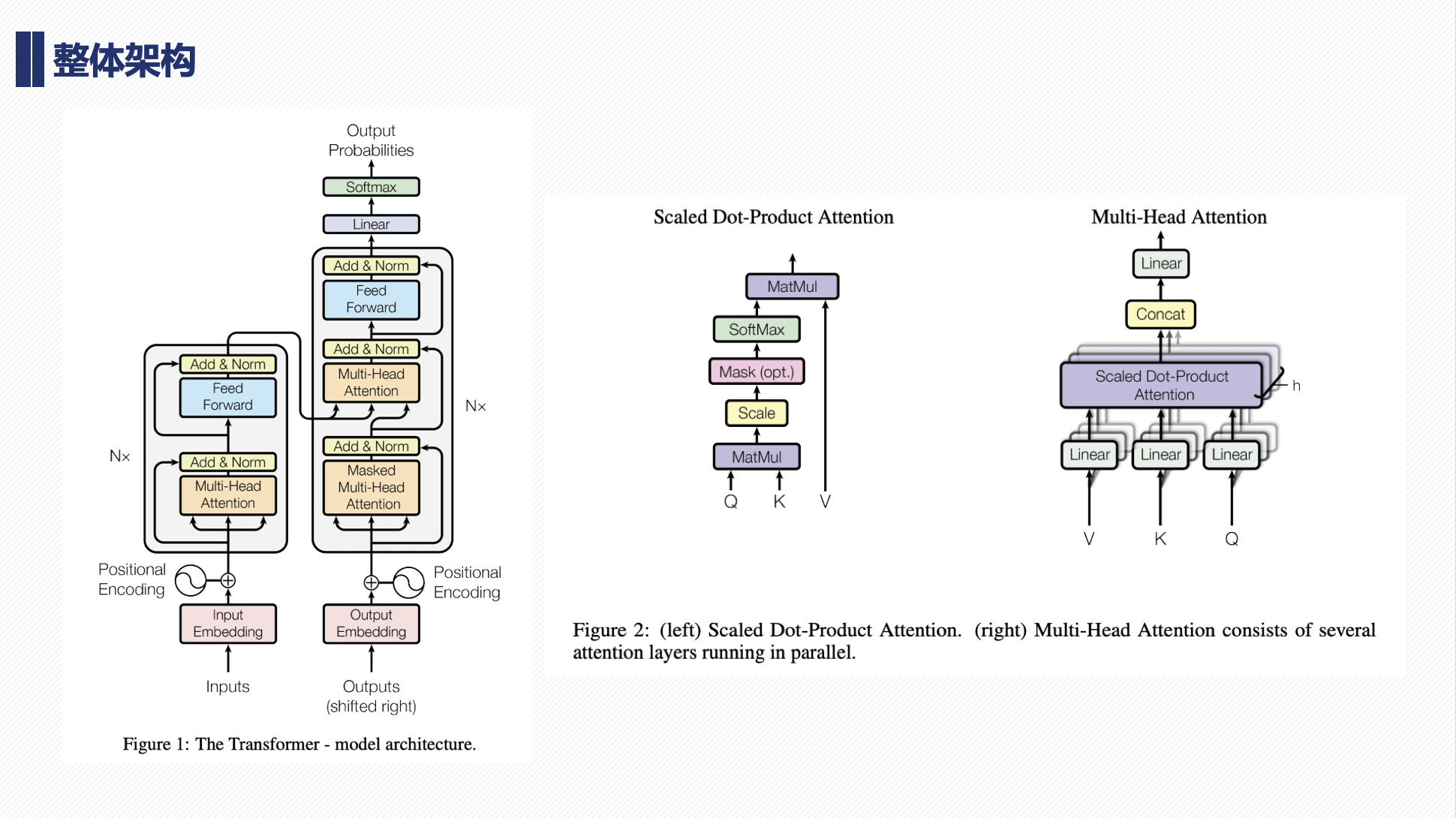

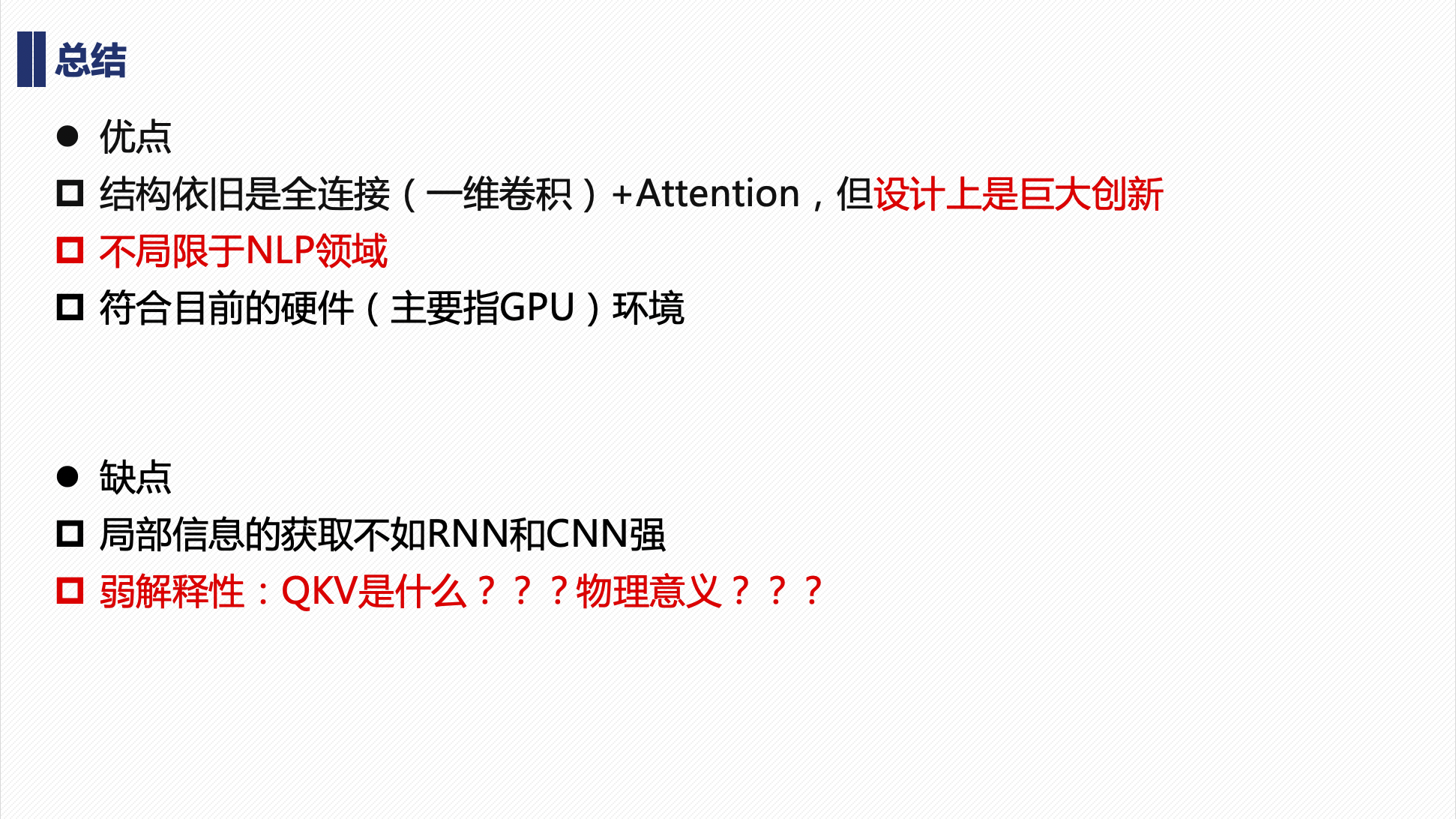

Transformer

懒得写字,直接放PPT。